一项针对全球数十家学术机构的学者开展的调查显示,许多大学的科学家对人工智能(AI)研究可用的算力资源感到沮丧。

相关研究论文已于近日发布在预印本服务器arXiv上,指出学者难以接触到最先进的计算系统,这可能阻碍他们开发大型语言模型(LLM)和其他AI研究的进展。

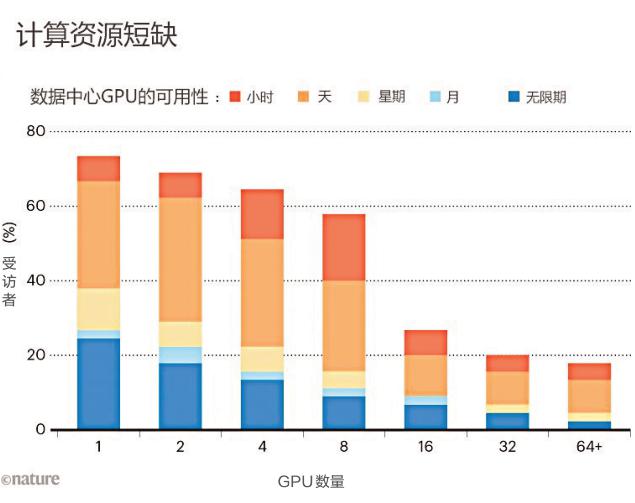

(图片来源:nature)

具体而言,学术研究者往往没有资源获取足够强大的图形处理器(GPU)——这些电脑芯片常用于训练AI模型,且价格昂贵,可达数千美元。相比之下,大型科技公司的研究者预算更高,可以在GPU上投入更多资金。“每增加一块GPU,就能提升更多算力。”美国布朗大学计算机科学家、该研究的合著者Apoorv Khandelwal表示,“虽然行业巨头可能拥有数千块GPU,但学者可能只有几块。”

“学术界与行业界的模型差距巨大,但本可以小得多。”美国华盛顿特区非营利AI研究机构EleutherAI的执行董事Stella Biderman说。她表示,对这一差距的研究“至关重要”。

为了评估学者可用的计算资源,研究团队对35家机构的50名科学家进行了调查。受访者中,66%对自己的算力满意度打了3分及以下(满分5分)。“他们根本不满意。”Khandelwal说。

各大学在GPU访问设置上有所不同。有些学校设有供各部门和学生共享的中央计算集群,研究人员可申请GPU使用时间。另一些机构可能为实验室成员直接购买机器。

柱状图揭示了调查的结果:学者通常只能有限地访问图形处理器,这进而限制了他们训练机器学习模型的能力。

一些科学家表示,他们不得不等待数天才能使用GPU,并指出在项目截止日期前后等待时间特别长。调查结果还凸显了全球算力访问的差异。例如,有受访者提到在中东地区难以找到GPU。仅有10%的受访者表示,他们可以使用英伟达的H100GPU,这是专为AI研究设计的高端芯片。

这一障碍极大地加剧了预训练过程的难度,即向大型语言模型(LLM)输入海量数据集的过程变得尤为困难。“由于成本高昂,大多数学者甚至不敢涉足预训练领域的研究。”Khandelwal指出。他和同事坚信,学者在人工智能研究中带来了独一无二的视角,而算力的匮乏可能会严重制约这一领域的未来发展。

“为了长期的增长和技术发展,拥有一个健康、有竞争力的学术研究环境至关重要。”美国布朗大学计算机科学和语言学学者、该研究的合著者Ellie Pavlick说,“相比之下,在行业研究中往往存在显著的商业压力,这有时会促使研究人员急于求成,减少了对未知领域的探索。”

研究人员还深入探究了学者如何在算力资源有限的情况下更高效地进行利用。他们测算了在使用1至8块GPU的低资源硬件环境下,预训练多个大型语言模型(LLM)所需的时间。尽管面临资源限制,学者仍成功训练出多个模型,但这一过程耗时更长,并要求他们必须采用更为高效的方法。

“我们实际上可以延长现有GPU的使用时间,从而在一定程度上弥补与行业界的差距。”Khandelwal说。

“在有限的计算资源上竟然也能训练出比许多人预期中更大的模型,这确实令人惊叹。”德国萨尔布吕肯萨尔兰大学神经显式模型研究者Ji-Ung Lee表示。他进一步指出,未来的研究可以聚焦小公司行业研究者的经历,因为他们同样在计算资源获取上面临困境。“并非所有有能力获取无限算力的人都能够如愿以偿。”他补充道。

猜你喜欢

猜你喜欢 因业绩预告披露净利润与实际

因业绩预告披露净利润与实际  第32届中国厨师节在福州举办

第32届中国厨师节在福州举办  生成式AI如何照进新零售?良

生成式AI如何照进新零售?良  水滴保险经纪积极参与“金融

水滴保险经纪积极参与“金融  半导体板块涨3.46% 利扬芯

半导体板块涨3.46% 利扬芯  突破,量产!透过“热词”看

突破,量产!透过“热词”看  第二届“新时代·新影像”中

第二届“新时代·新影像”中  国家开放大学首届新商科创新

国家开放大学首届新商科创新