IBM AI 模拟芯片包括 64 个模拟块,每个块都可以用作神经网络中的一层。图片由IBM提供

矩阵乘法是人工智能模型的重要组成部分,它使用内存计算架构来防止数据进出处理器的混洗。然而,尽管此功能具有速度和效率优势,但设计人员仍然必须结合数字电子设备来调整和读取内存计算单元中的权重,以便为设计提供足够的多功能性。

(资料图片仅供参考)

(资料图片仅供参考)

本文着眼于IBM的最新进展,让读者了解该芯片的模拟和数字电子器件如何运行,以提高人工智能部署的效率。

IBM 芯片执行一对一矩阵数学运算

现有计算机系统的一个关键限制是冯·诺依曼架构,它对处理器和内存之间传输数据的计算施加了上限。对于生成式 AI中的矩阵乘法,需要执行数千或数百万次乘法运算,这种限制可能会导致显着的延迟和性能低下。

神经网络层之间的每个桥梁都需要矩阵乘法,这可能会对大型网络提出主要的计算要求。然而,IBM 的模拟 AI 芯片几乎可以立即实现这一目标。图片由迈向数据科学提供

为了规避这一限制,IBM 采用了模拟内存计算方法来消除昂贵的数据传输和乘法运算。通过对记忆电阻元件网格的权重进行编程,芯片只需输入必要的信号并读取模拟输出即可执行矩阵乘法。

一种新型混合信号人工智能芯片

几个小组已经证明了使用模拟计算机与数字计算机来执行复杂数学运算的可行性。然而,从根本上来说,计算世界是在数字化的基础上运行的。虽然模拟计算确实可以更快地执行计算,但要使产品真正可用,需要模数“桥”。

IBM 的上一代模拟 AI 芯片采用类似的架构,其中 8x8 的 PCM 设备阵列可以完成矩阵运算。图片由arXiv提供。

IBM 的目标是为这座“桥”提供由64 个“块”组成的新芯片,每个“块”包含一个 256×256 相变存储器突触单元阵列。每个单元都包含模数转换器和数字处理单元,以在编程时执行所需的缩放和激活。

该芯片本身在 CIFAR-10 图像数据集上表现出 92.81% 的准确率,表明它可以执行高质量的神经网络任务。此外,吞吐量高达63.1 TOPs,能效高达9.76 TOPs/W,不仅体现了计算性能,还体现了设备的能效。

在数字领域利用模拟

随着更复杂的计算需求的出现,其中要求最高的(在本例中为人工智能)可能会引导设计人员采用新的架构和技术。虽然模拟计算机尚未准备好取代数字计算机,但其独特的优势与可编程内存计算操作相结合,使其成为研究人员前进的有用工具。

IBM 模拟 AI 芯片缩小了模拟与数字之间的差距,展示了模拟计算机采用的关键一步。通过添加仿照 IBM 设备建模的芯片,数字计算机可以轻松调整和使用具有更好性能和效率的复杂 AI 模型。

本文由EETOP编译自allaboutcircuits

猜你喜欢

猜你喜欢 美国:通胀预期为何出现“背

美国:通胀预期为何出现“背  美联储激进加息对A股和港股

美联储激进加息对A股和港股  “赋能金融,共筑安全”知虎

“赋能金融,共筑安全”知虎  “AI四小龙”上市之路各不相

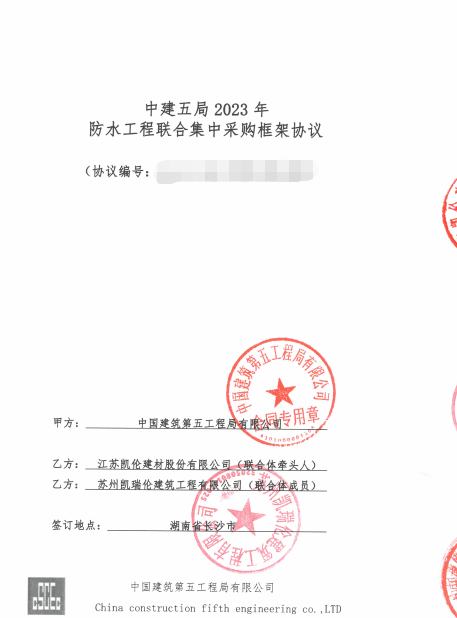

“AI四小龙”上市之路各不相  再创佳绩!凯伦股份与中建五

再创佳绩!凯伦股份与中建五  深圳坪山新能源车产业园一期

深圳坪山新能源车产业园一期